电话

02088888888

包括许多不同领域,如多语言文本、医学、建筑、舞蹈动作、电影标题和文本到表格生成。如需获取,您可以在公众号后台回复关键词“姐夫2021”。接下来先来看一下,这个被誉为行业风向标的Jeff认为机器学习的五大趋势有哪些。

包括许多不同领域,如多语言文本、医学、建筑、舞蹈动作、电影标题和文本到表格生成。如需获取,您可以在公众号后台回复关键词“姐夫2021”。接下来先来看一下,这个被誉为行业风向标的Jeff认为机器学习的五大趋势有哪些。

快速浏览:

\n潮流1:增大模型以提高人工智能功能 \n潮流2:机器学习效率持续改善 \n潮流3:人工智能应用对个人有益 \n潮流4:人工智能推动科学研究和医学健康 \n潮流5:对机器学习的理解加深 潮流1:增大模型以提高人工智能功能在过去一年中,语言模型的参数规模继续增长,超过了1750亿的GPT-3。举例来说,DeepMind的Gopher拥有2800亿个参数,而微软和英伟达合作推出的威震天-图灵则拥有5300亿个参数。谷歌使用自家的GShard和GLaM模型,能够达到6000亿和1.2万亿级别。这些模型训练所使用的数据集规模也在同步增加。随着

数据集和模型规模的增加,AI在传统NLP任务方面的准确性显著提升,还在许多新能力上取得了突破。Quoc Le团队提出了一种名为Instruction Tuning的新微调方法,该方法具有代表性的研究。新模型FLAN在未经过训练的任务上展现出了比GPT-3少样本版本更强的零样本学习能力。

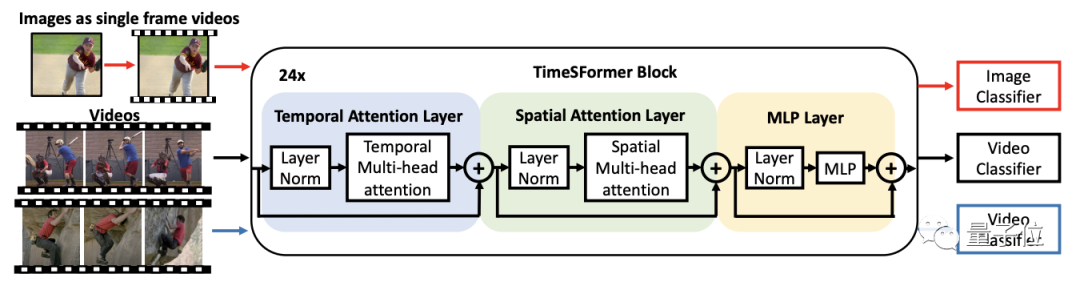

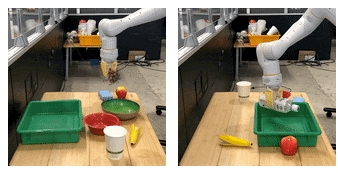

和谷歌I/O大会展示的LaMDA模型,在开放式多轮对话领域有了重大突破。除了语言模型以外,Transformer架构在图像和视频方面也刷新了模型规模和性能基准,成为了本年度的热点。在这方面,谷歌代表性的研究是Vision Transformer (ViT)和Video ViT。另外一个重要的发现是,在视频任务中使用图像和视频数据进行同时训练可以提高模型的性能。在图像生成领域,扩散模型(Difusion Model)在过去一年中崭露头角,成为GAN的强劲竞争对手。Cascad扩散模型SR3以低分辨率图像作为输入,可以从纯噪声中生成对应的高分辨率图像。在多模态模型方面,增加模型规模也使得机器人获得了新的能力。当机械臂学会了“将葡萄放入碗中”这一任务后,它就可以执行一个全新的任务,即“将水瓶放入托盘中”,而无需额外的学习。Jeff总结说,这些大型模型通常采用自监督学习方法,这一趋势让人感到兴奋。使用

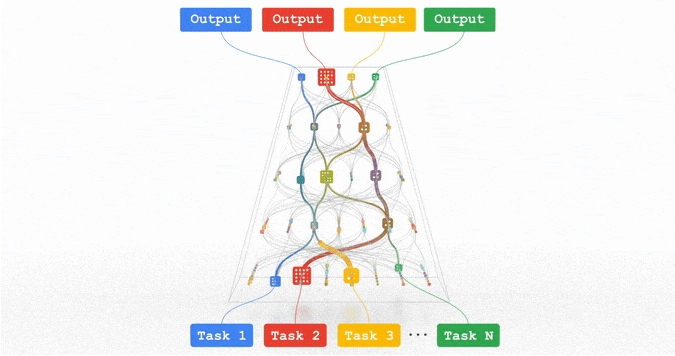

既可以显著减少工作量,又可以在处理长尾任务时获得更好的表现。谷歌的人工智能的下一个重点是研发名为Pathway的新型稀疏模型架构,将其训练成一个通用模型,能够执行成千上万种不同的任务。

趋势2:机器学习效率不断提升

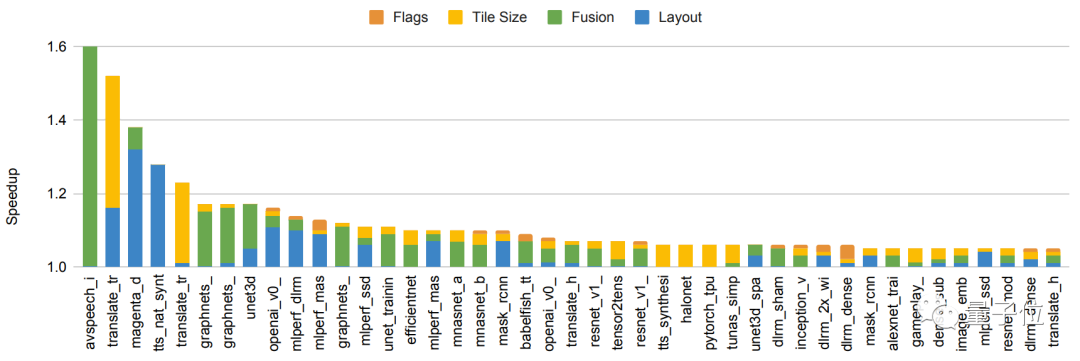

随着参数规模和数据量的增加,模型训练面临新的挑战。为了应对挑战,谷歌在加速芯片、编程器、模型结构和算法方面都取得了进步。关于芯片方面,新发布的TPUv4在性能方面较上一代提高了2.7倍,可以通过高速网络连接以支持超大型模型的训练。在移动设备上,新一代Pixel6手机配备了全新的Tensor处理器,能够在手机上实现4k60帧视频处理,以及实时机器翻译。在编译器方面,谷歌发布了GSPMD系统,它基于XLA编译器实现自动并行化。即使硬件没有得到改进,我们也可以实现在150个模型上性能整体提升5%至15%,甚至在某些特定情况下提高了2.4倍。这项成果已经被应用于GShard-M4、LaMDA、ViT等多个大型模型中。在

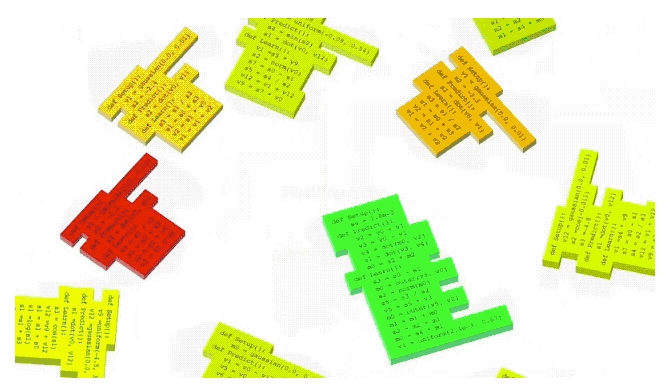

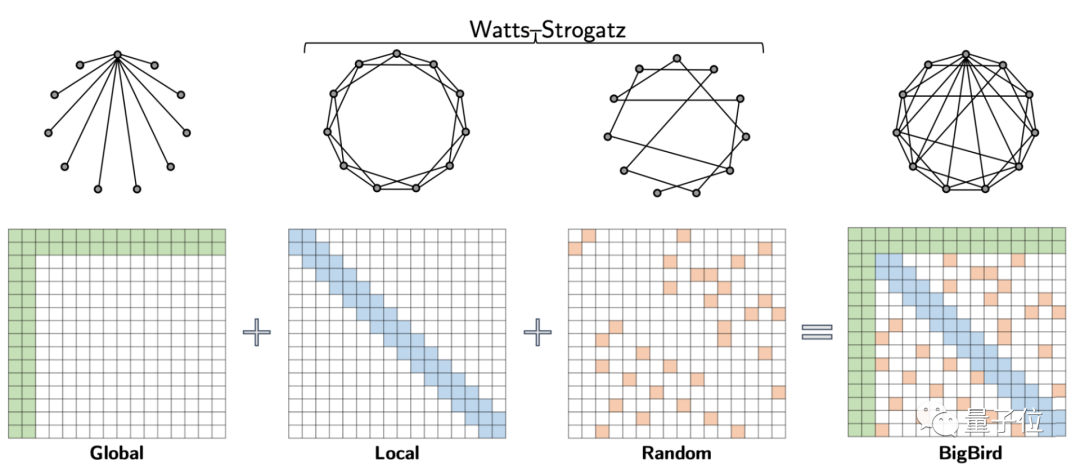

架构方面,有一个可以提高效率的方法,那就是依靠人类的创造力进行设计。Transformer的各种不同版本在过去一年中表现出色,频繁登上了自然语言处理和计算机视觉领域的榜单。机器驱动的神经架构搜索(NAS)是另一种方法,可以大幅减少算法开发的工作量。尽管NAS本身需要大规模计算和高昂成本,但总的来说可以显著减少下游开发和生产环境中的计算量。通过NAS方法搜索出来的Evovled Transformer,在参数减少了37.6%的情况下,获得了0.7%的英德翻译性能提升。在视觉任务中,NAS方法所得的Efficientnetv2模型的训练速度比之前的SOTA模型提高了5-11倍。AutoML-Zero不仅使用了模型架构,还运用了NAS方法来寻找更有效的强化学习/监督学习算法。对于算法而言,利用稀疏性的增加是一个重要的进步。谷歌的Switch Transformers相较于T5模型,具有更高的训练效率——可以提高七倍。同时Switch Transformers比T5模型更为稀疏。GLaM模型结合了Transformer和Mixer of Expert风格层,相较于GPT-3,其训练和推理成本分别减少了3倍和2倍。此外,BigBird模型采用稀疏性的方法,降低了Transformer核心机制中注意力模块的计算成本。尽管在稀疏性方面取得了如此多的成就,Jeff Dean仍认为当前的研究仅仅探索了这个领域的表面。未来将会继续深入研究,有着更高的潜在回报。趋势三:AI应用对个人的价值更大。除了上述趋势之外,Jeff Dean还关注移动设备上的个性化AI应用。由于机器学习的发展和处理器的创新,手机可以更连续有效地感知周围环境,用户体验也更加丰富。一些日常使用的功能,比如摄影计算和实时翻译,都带来了改变。同时,我们也进一步加强了隐私保护措施。以计算机视觉中的摄影HDR+功能为例,即使在极低光线条件下拍摄,也能够展现更加真实的效果。

实时跨语言交流也成为一个重要趋势。随着自监督学习和noisy student training自训练算法等技术的进步,语音识别的准确性取得重要突破,对于嘈杂、重叠语音等环境以及跨语言任务的表现都有明显的改善。

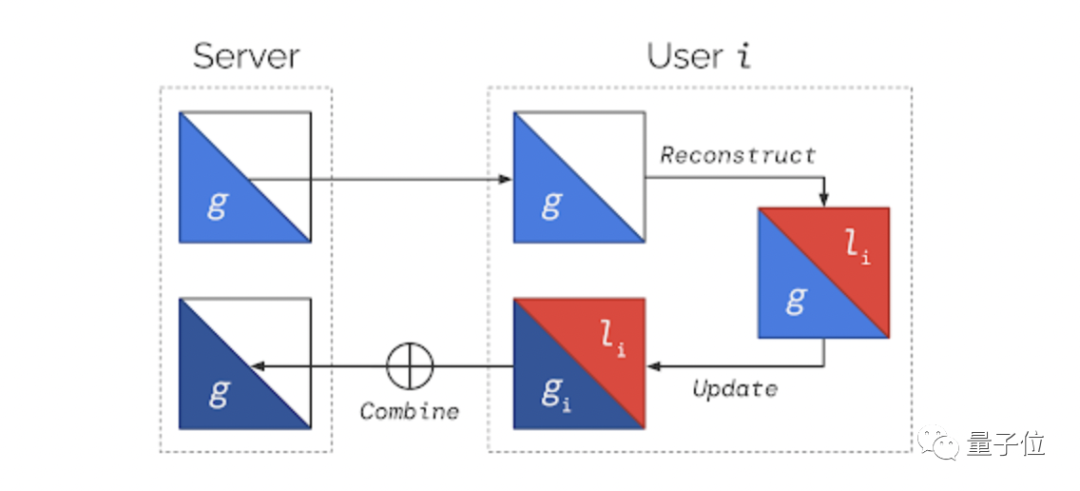

的日常互动也变得越来越顺畅,例如自动拨号、机器学习代理,即使是常见的短期任务,也可以通过智能文本选择工具来提升。有一些小例子进一步展示了人工智能的益处,比如注视识别技术,可以防止在使用手机屏幕时自动变暗。机器学习为确保个人和社区安全提供了全新的方法。比如说,使用“可疑信息警告”来应对疑似网络钓鱼攻击,而“安全路线”则可以帮助识别和检测何时需要刹车并提供备用路线提示。考虑到这些新功能所涉及的数据具有敏感性,隐私计算也因此受到了关注。安卓系统通过私有计算核心处理数据,确保不会被任何APP共享,同时还阻止内部功能直接访问网络。趋势4:人工智能在科学研究和医学健康领域的推动\n近年来,我们已经看到机器学习在基础科学领域的影响越来越广泛。从物理学到生物学,都有大量令人兴奋的实际应用案例。同时,人工智能也在医学健康领域发挥着越来越重要的作用。

计算机视觉作为代表已经在各个领域得到了应用,解决了个人和全球性的问题。

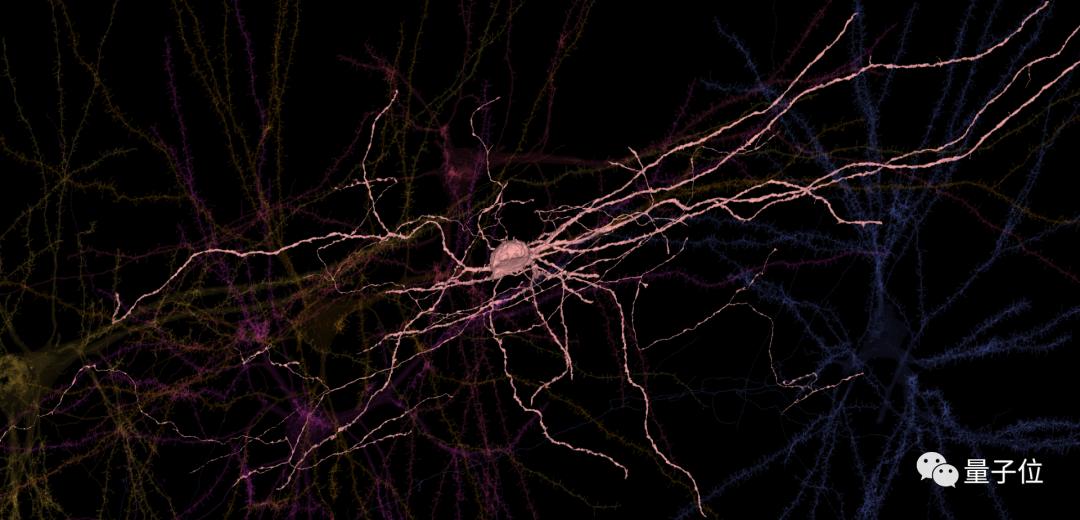

的作用不仅仅是协助医生日常工作,同时也能扩展对神经生理学的理解,还可以提供最准确的天气预报和优化救灾工作。去年,谷歌与哈佛大学合作开展了一个规模庞大的研究,探究人类大脑皮层的突触连接,并且成功重建了人类大脑组织图像。

ps:上图展示了成年人大脑中的860亿个神经元中的6个

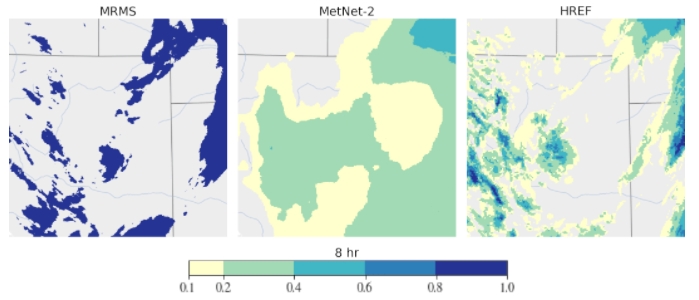

远动力。如果考虑到外界影响,计算机视觉在全球挑战应对方面也发挥着重要作用,例如基于深度学习的天气预测,可更准确地预报未来12小时的天气和降水情况,比传统的物理模型更加精准。在文档、游戏以及芯片上的自动化设计布局,以及在医学、人类健康和应对气候变化方面,

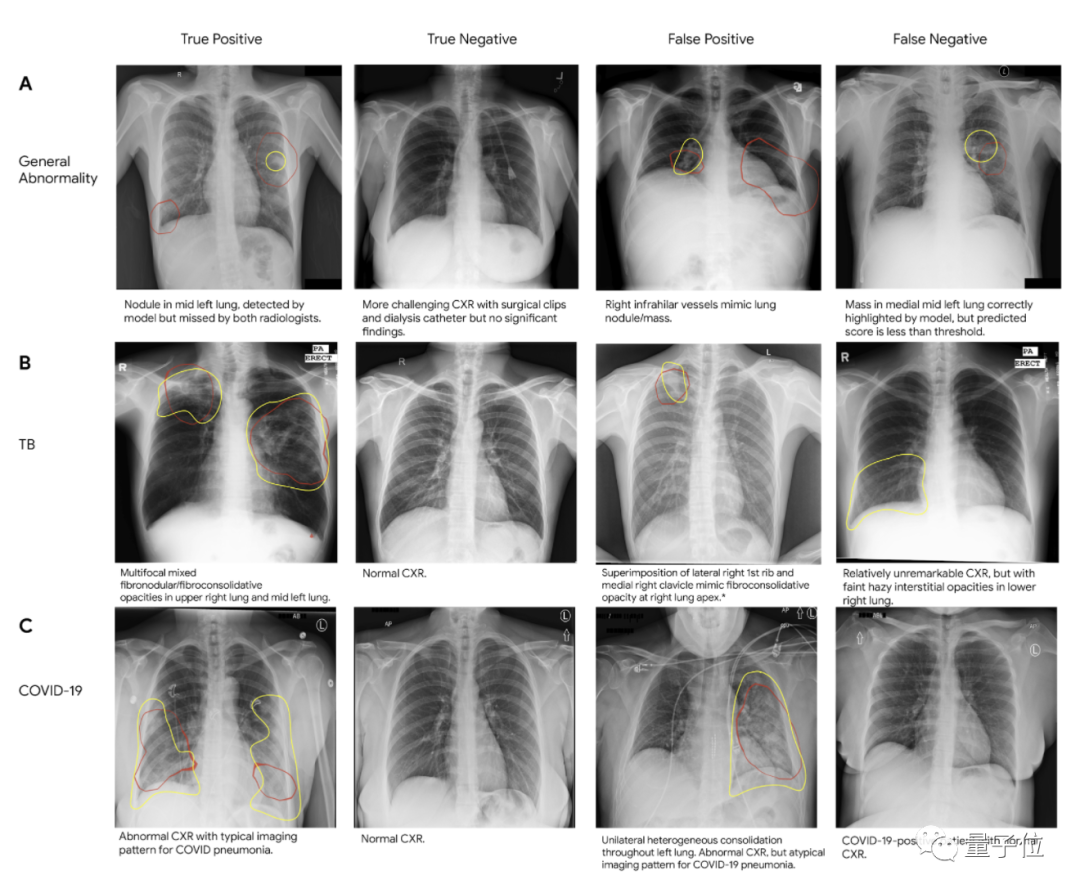

发挥着至关重要的作用,不容忽视。以医学健康为例, 在基因组学研究中,机器学习能够处理序列数据,发现基因组数据的隐藏特征,并加速个性化健康基因组信息的应用。Jeff Dean还强调了在疾病诊断方面的重要性,特别是在医学成像领域的应用,比如改善乳腺癌筛查、肺癌检测、加速癌症的放射治疗、标记异常的X射线和前列腺癌早期活检等方面。

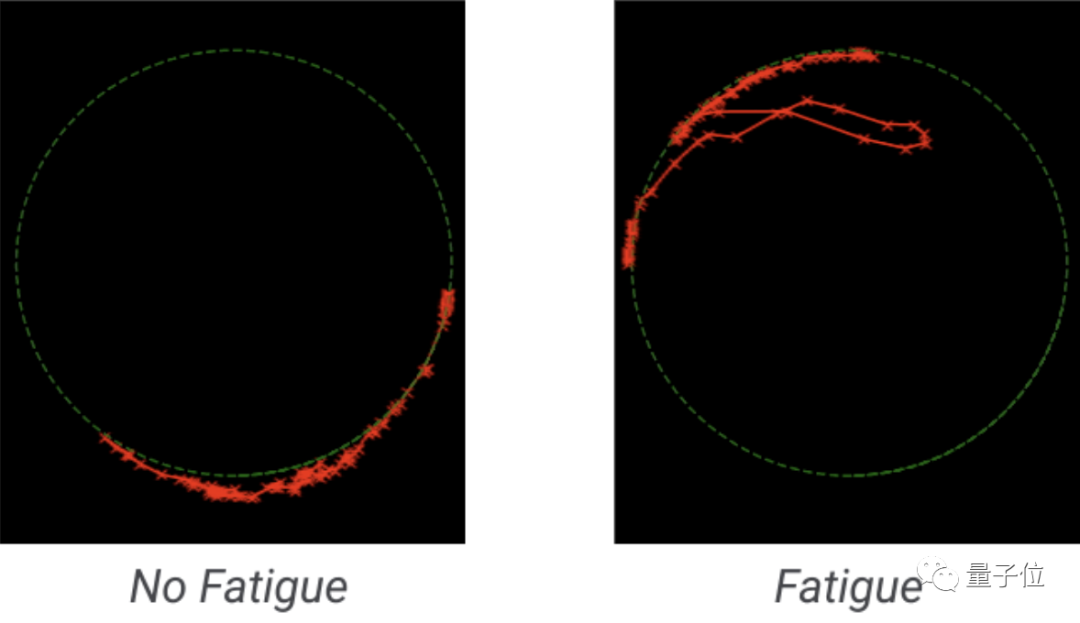

另一个引人关注的方向是利用自然语言处理技术,对结构化数据和医疗记录进行分析,从而帮助临床医生提供更准确的诊断和护理。尽管机器学习对于扩大信息获取渠道和提高临床诊断的准确性非常关键,但我们也注意到一个同样重要的新趋势正在兴起:智能手机上的健康功能,可帮助用户自行评估健康状况。

趋势5:建立负责任的人工智能随着机器学习在社会中得到越来越广泛的应用,确保其使用更公平公正正逐渐成为下一个技术发展重点。

一个关键的领域是基于用户活动的推荐系统,最新的研究揭示了提高单个组件和整个推荐系统公平性的方法。

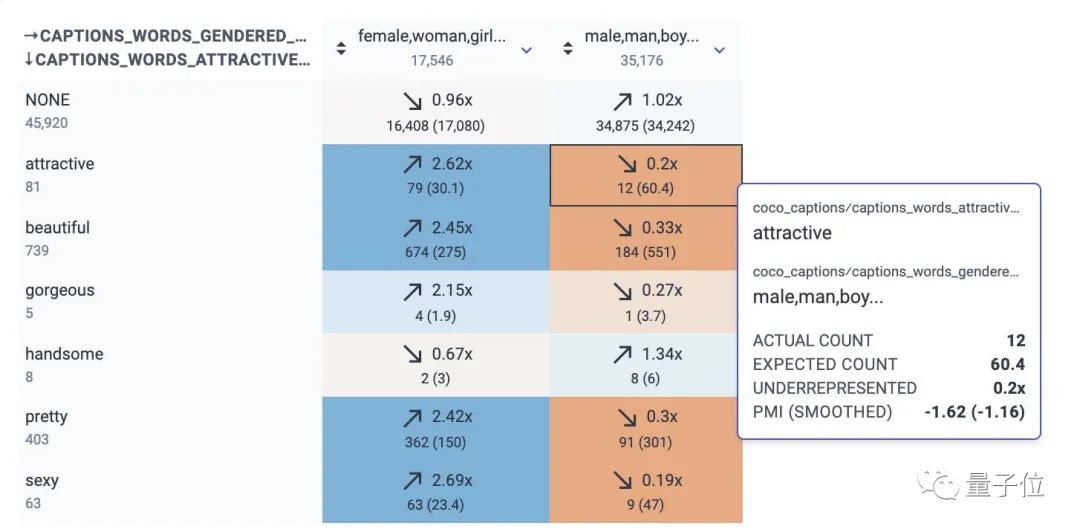

在机器翻译中的应用同样非常重要,因为大多数机器翻译系统仅翻译单个句子,缺少周围语境的支持。它们通常会强化与性别、年龄或其他领域相关的偏见。谷歌去年发布了一个数据集,可用于研究翻译维基百科传记时的性别偏见。在部署机器学习模型时,一个常见的问题是分布转移。当模型所基于的数据统计分布与输入数据的统计分布不匹配时,模型的行为可能会变得难以预测。最新的研究表明,在最近的工作中,谷歌的深层Bootstrap框架能够帮助比较和理解模型在不同情况下的表现,使得模型更好地适应未知环境,并且不会对固定的训练数据产生太大的偏见。在机器学习领域,除了

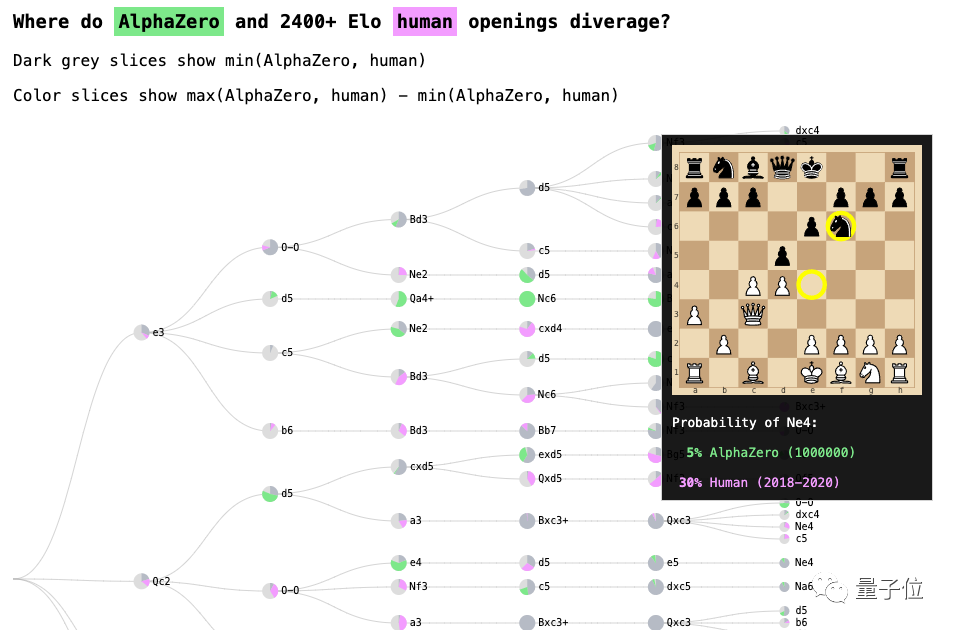

,还有数据收集和数据集管理方面的相关研究。谷歌也在解决处理网上侮辱行为、交互式分析和调试模型、机器学习可解释性(例如AlphaZero国际象棋系统)、以及改善社区生活等方面的问题。无论如何,我们要再次强调一个愿景:打造负责任的人工智能。在这篇博文的评论区,我看到了一个熟悉的名字。那个引发了Jeff Dean陷入歧视风波的前员工名叫Timnit Gebru,她也转发了一些相关内容。 不过,这画风……嗯,有些尴尬。

不过,这画风……嗯,有些尴尬。来,对于感兴趣的朋友们,可以点击下方链接查看详细报告。

还有,请别忘了在公众号后台回复"姐夫2021",获取27个谷歌开源工具和数据集的总结。直达链接: https://ai.googleblog.com/2022/01/google-research-themes-from-2021-and.html

邮箱:youweb@qq.com

Q Q:http://wpa.qq.com/msgrd?v=3&uin=88888888&site=qq&menu=yes